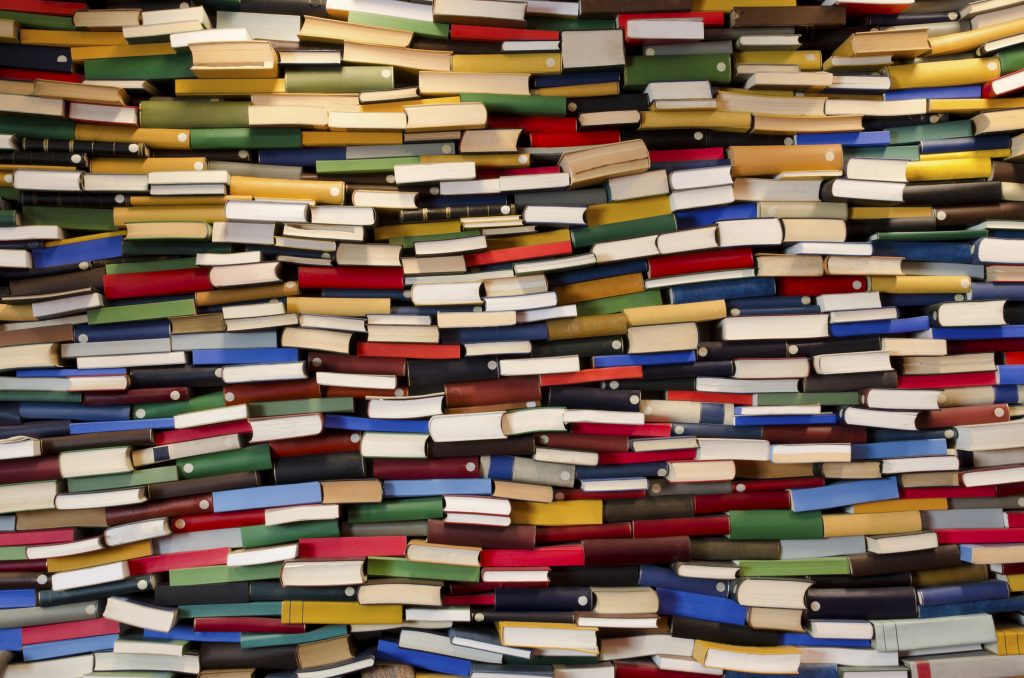

Sedan mars 2020, då WHO förklarade att sjukdomen nu var en pandemi, har flera hundra tusen vetenskapliga artiklar om covid-19 publicerats. Sonja Aits och hennes forskargrupp vid Lunds universitet utvecklar nu textanalysverktyg som använder artificiell intelligens för att hitta relevant information.

– Det finns i dagsläget mer än 300 000 vetenskapliga artiklar som kan innehålla information relaterad till covid-19. Varje vecka blir det fler. Det behövs ett verktyg som snabbt kan kategorisera och prioritera bland alla dessa texter så att de som söker bland all information hittar rätt, säger Sonja Aits som i sin forskning kombinerar artificiell intelligens med biomedicin.

Det är här textanalys med hjälp av artificiell intelligens kommer in. Det kan användas för att flagga upp de texter som är mest relevanta och skulle även kunna tränas till att skilja ut forskning av högst kvalitet.

Tusentals pusselbitar

–AI-systemet kan även extrahera nyckelinformation om exempelvis kopplingar mellan läkemedel och sjukdomen, eller mellan viruset och olika mänskliga proteiner, vilket kan bli värdefullt när forskare söker uppslag till möjliga behandlingar. Ingen människa kan hålla pusselbitar från tusentals artiklar i huvudet, säger Sonja Aits.

Systemet kan också användas som stöd för beslutsfattare.

– Oavsett om du ska bedöma kunskapsläget för att ta fram en politisk strategi eller få fram underlag för nya riktlinjer, behöver du få hjälp att skapa dig en relevant överblick på ett snabbt och säkert sätt. Systemet skulle också kunna utvecklas vidare för att avslöja desinformation.

Variationen en utmaning

Även om teknologin för att genomföra textanalys med hjälp av AI har utvecklats under senare år, finns en hel del utmaningar kvar att lösa. Sonja Aits listar några:

– Utmaningen med vetenskapliga artiklar är att de är så heterogent skrivna. Här används förkortningar som inte är standardiserade, samma protein kan ha flera olika namn och det kan finnas stavfel och grammatiska fel som ställer till det. Variationen i språket, något som en läsare uppfattar som positivt, blir i stället ett problem för datorn.

Mycket information finns också att hämta i patientjournaler. Även här brottas man med att materialet är heterogent.

– En läkare kan beskriva symtom som att ”personen hostar mycket”, eller ”personen har hosta”. För oss är det samma sak, men för en dator är det helt olika saker.

Tack vare språkanalysmodeller som är baserade på maskininlärning med neurala nätverk har man kommit en bit på väg att hantera problemet.

Sekretess och träningsdata

– Datorn lär sig känna igen variationer i språket men det krävs stora mängder träningsdata. Eftersom patientdata omges av sekretess är det inte alltid så lätt att få tillgång till tillräcklig mängd träningsdata.

För att komma runt problemet tränas språkanalysmodellerna i två steg. Först grovtränas datorn med stora mängder fritt tillgängliga texter i samma språk. På så sätt kan nätverket ”lära sig” rent allmänt hur språket är strukturerat och vilken variation som kan finnas. Därefter finjusteras modellerna med material från riktiga patientjournaler, men då räcker det med en mindre mängd träningsdata.

Även om arbetet med språkanalysmodeller fortfarande är under utveckling ser Sonja Aits stora möjligheter för framtiden.

– Jag tror att vi redan har svar på många av våra frågor men vi hittar dem inte bland den stora mängden information. Här skulle våra textanalysverktyg kunna vara till stor hjälp.

Text: TOVE SMEDS och EVA BARTONEK ROXÅ